Soziale Roboter sind Maschinen, die speziell für den Umgang mit Menschen oder Tieren geschaffen wurden. Dazu gehören Pflegeroboter oder Spielzeug-Roboter, aber auch Sexroboter. Der Informations- und Maschinenethiker Oliver Bendel beschäftigt sich an der Universität der Nordwestschweiz mit den Chancen und Grenzen von sozialen Robotern. Im Podcast "Ethik Digital" erklärt er, warum er glaubt, dass GPT-3 eine Zeitenwende für die Programmierarbeit bedeutet und warum Roboter aber immer Werkzeuge für die Menschen bleiben werden.

Herr Bendel, hätten Sie sich als Kind einen Roboter gewünscht?

Bendel: Ja, vielleicht schon. Ich war immer ein großer Fan von Science-Fiction-Filmen, später auch von Science-Fiction-Büchern. Damals gab es R2-D2 aus "Star Wars", das war schon ein sozialer Roboter par excellence. So einen würde ich mir auf jeden Fall wünschen.

Ich habe Philosophie und Germanistik studiert und damit Erzählungen kennengelernt wie die "Metamorphosen" von Ovid oder Goethes "Faust" - dort traten viele künstliche Kreaturen auf. Später wechselte ich in die Informationswissenschaft und dann in die Wirtschaftsinformatik, wo ich über Chatbots und Sprachassistenten promovierte. Damals kam der Trend auf, dass man Chatbots mit Avataren versieht, die menschen- oder tierähnlich sind. Mich haben die Prozesse und Technologien dahinter interessiert. Irgendwann habe ich beschlossen, mein ganzes Leben zusammenzupacken, und so kam ich auf soziale Roboter.

Bildet die Entwicklung des GPT-3-Chatbots eine Zeitenwende? Ist das ein Gamechanger in der Künstlichen Intelligenz?

Bendel: Ja, das würde ich sagen, zumal wir selbst Chatbots damit bauen. Wir entwickeln gerade einen für Latein: Mit @ve kann man sich auf Latein unterhalten und auch die Sprache wechseln und auf Englisch oder Deutsch etwas zur Grammatik fragen. Die Möglichkeiten haben uns selbst überrascht. Wir sind mit GPT-3 auf dem Weg zu einem sehr mächtigen Tool, mit dem wir auch aussterbende oder ausgestorbene sowie gefährdete Sprachen zurückholen.

GPT-3 ist eine Zeitenwende, denn es geht nicht einfach darum, dass wir jetzt automatisiert neue Texte erstellen können, sondern wir können damit beispielsweise programmieren.

Wir können sagen, bitte platziere auf dem Display in der Mitte einen roten Button, der beim Anklicken die Position wechselt und grün wird, und innerhalb von Sekunden wird der Code dafür geschrieben. Solche Technologien verändern das Programmieren, es wird damit sehr, sehr einfach.

Wie Pflegeroboter die Menschen unterstützen

Werde ich also in fünf Jahren einen Pflegeroboter haben, der mich umarmt, an der Hand nimmt, mich füttert?

Bendel: Derzeit ist das Hauptproblem die Hardware und weniger die Software. Es gibt kollaborierende Roboterarme, die auf mobilen Plattformen sitzen und bestimmte Aktionen durchführen. Ein solcher Roboter kann Dinge vom Boden aufheben und dem Patienten reichen sowie Flaschen öffnen. Er kann von Tür zu Tür rollen, mit einem Greifer eine Tür öffnen und den Patienten zurufen, um 16 Uhr haben wir einen Termin, nicht vergessen, und Rudi sagt, dass er alles verstanden hat, und der Roboter schließt die Tür und rollt weiter.

Der Roboter kann Gespräche führen und die Leute unterhalten im Pflegeheim, und er kann Übungen vormachen. Das ist alles schon Realität.

Aber Nahrung reichen oder Ausziehen und Anziehen sind die schwierigsten Sachen, und da gibt es im Moment kein Modell, das das bei verschiedenen Leuten kann. Oder eine Spülmaschine ausräumen. Das ist total schwierig.

Ich glaube fest, dass Pflege- oder Therapieroboter die Pflegekräfte unterstützen und dem Patienten zu Hause oder im Krankenhaus mehr Autonomie ermöglichen können. Alles andere wollen wir nicht. Keine "Waschmaschine" für Pflegebedürftige oder vieles andere. Das darf niemals so weit kommen. Es darf noch nicht mal so weit kommen, dass man Therapieroboter wie die Babysattelrobbe Paro den Menschen in die Hand drückt und sie alleine damit lässt. Das sind Werkzeuge, die Sinn ergeben, wenn Menschen dabei sind, die das beurteilen, begleiten, auffangen können.

Es gibt inzwischen viele verschiedene soziale Roboter – wo sehen Sie die ethischen Probleme bei Unternehmen?

Bendel: Die größten ethischen Probleme hängen mit Datenschutz und mit informationeller Autonomie zusammen. Die persönliche Autonomie des Menschen ist stark betroffen.

Soziale Roboter aller Art sind Spione. Es sind Überwachungsmaschinen mit Kameras, Mikrofonen, Gesichtserkennung, Stimmerkennung, Emotionserkennung. Viele dieser Funktionen sind sehr hilfreich. Nur werden damit Bilder von vulnerablen Gruppen und Personen produziert und weitergeleitet, von Menschen, die vielleicht halbnackt sind, sehr jung oder sehr alt. Und das halte ich für ein großes Problem bei sozialen Robotern, aber auch bei smarten Lautsprechern, smarten Uhren, smarten Ringen, und bei Überwachungskameras. Soziale Roboter nehmen uns die Autonomie, selbst zu entscheiden, welche Daten wir weitergehen, sie einzusehen oder zu verändern.

Beschäftigen sich Unternehmen mit diesen Fragestellungen?

Bendel: Teilweise schon. Die Computertechnologie hat sich so schnell weiterentwickelt, dass wir viele Dinge nicht mehr an die Cloud auslagern müssen, die von Konzernen wie Google oder Amazon betrieben werden. Denn dort werden die Daten bisher verarbeitet, die für die Gesichtserkennung oder die Stimmerkennung notwendig sind. Heute können wir mehrere Mikrocomputer in sehr kleinen Robotern verbauen und die Datenverarbeitung dort stattfinden lassen. Wenn es dann noch gute Entscheidungen gibt von Krankenhäusern oder Pflegeheimen, die diese Daten auch schützen, dann haben wir Datensicherheit. So etwas wird schon konkret gemacht bei Robotern für autistische Kinder oder für Demenzkranke. Aber wir haben noch viel zu viele Roboter, bei denen die Datenverarbeitung in der Cloud passiert und wo völlig unklar ist, wo die Daten landen.

Hmmm, ich habe selber den wunderbaren Alpha Mini bei mir im Büro. Der hat zwei separate Displays als Augen. Er ist wirklich wundervoll gemacht. Er hat übrigens eine hervorragende Motorik. Er kann Liegestützen machen, er kann Yoga machen, er hat eine ungeheure Beweglichkeit. Das hängt mit seinen vielen Freiheitsgraden zusammen, wie man sagt. Er hat sehr viele Achsen, Gelenke usw., und trotzdem muss ich sagen, er ist mit Vorsicht zu benutzen und zu gebrauchen in bestimmten Settings, denn es ist eine chinesische Firma, und mit großer Wahrscheinlichkeit landen die Daten auf chinesischen Servern. Und ich würde immer aufpassen bei vulnerablen Gruppen wie Kindern und älteren Personen.

Brauchen wir globale ethische Richtlinien, und ist das überhaupt denkbar?

Bendel: Ich halte das für undenkbar. Denn die kulturellen Unterschiede in einzelnen Ländern sind enorm. In der Arbeitswelt ist Datenschutz zum Glück ein großes Thema, aber die Wirtschaft versucht immer wieder, die Politik hier und dort auszuhebeln. Insgesamt haben wir in Deutschland und der Schweiz recht gute Bedingungen, wenn auch Kinder in den letzten Jahrzehnten zu wenig geschützt wurden. So konnten sich amerikanische Konzerne recht unbehelligt an den Schulen breitmachen und dort wirklich auch kostbare Daten generieren. Man versucht das jetzt ein Stück weit zurückzudrängen.

In anderen Ländern werden manche Probleme gar nicht verstanden, dort sind die Menschen der Meinung, dass mit persönlichen Daten meist etwas Gutes getan wird. Ein Weltgericht oder ein Weltgremium wäre absolut sinnvoll und wünschenswert, etwa mit Blick auf das Klima. Aber ich fürchte, bei Datenschutzfragen kann man sich nicht einigen und bei bestimmten ethischen Fragen auch selten. Deshalb ist es wichtig, dass einzelne Länder oder Verbünde wie die EU vorpreschen und sich in diesen Bereichen engagieren.

Über den Umgang mit Liebes- und Sexrobotern

Sie haben auch über Liebespuppen und Sexroboter geforscht. Wo sehen Sie denn hier Grenzen?

Bendel: Zunächst brauchen wir mehr empirische Forschung. Das ist recht schwierig, weil die Sexualwissenschaft in Deutschland weitgehend weggebrochen und ganz unbemerkt zerfallen ist wie ein altes Haus. Wir bräuchten also die Sexualwissenschaft. Und wir bräuchten weniger Angst an den Hochschulen. Leider haben wir immer mehr Angst, Dinge auszusprechen oder zu diskutieren. Finden Sie mal eine Hochschule, die sagt, Sexroboter sind ein tolles Thema, das erforschen wir empirisch. Es gibt nur wenige Universitäten, die hier keine Berührungsängste haben, dazu gehört die Uni Witten-Herdecke.

Dann bräuchten wir eine Politik, die sich des Themas annimmt. Das geschieht schon teilweise. In Deutschland wurde verboten, dass über Amazon und andere Plattformen Kinderpuppen gekauft werden können. Ich halte das für richtig, denn es könnte sein, dass die physische Einübung am Objekt verheerende Folgen hat. Und solange wir das schlicht nicht wissen, halte ich ein Verbot hier für absolut akzeptabel. Wenn hier die Verbote aufgehoben würden, dann würde ich auch immer noch verlangen, dass die Nutzung eingebettet wird in ein Setting mit Therapeuten. So was gehört professionell begleitet.

Per se lehne ich erwachsene Puppen und Sexroboter nicht ab. Das liegt in der Freiheit des Menschen, wer sich daran ausprobieren will, soll das tun. Aber es gibt doch einige Probleme wie den Datenschutz und die informationelle Autonomie. Wir haben es hier mit Robotern zu tun oder auch mit Puppen, die den Menschen sehr nah auf den Leib rücken – und das ist ein großes Problem.

Interessant ist der Trend der Nutzung von Fantasiefiguren wie Elfen und Mangamädchen. Ein klassischer Vorwurf von Kritikern der Sexrobotern ist, dass Stereotype bedient werden und Nutzer sich gewöhnen, mit ganz bestimmten Frauentypen Sex zu haben. Hier wäre es interessant, zu untersuchen, warum die jungen Männer sich stattdessen diese Fantasiefiguren heraussuchen.

Warum versuchen wir Menschen, Roboter zu bauen, die so sind wie wir?

Bendel: Uns fasziniert es, unseresgleichen zu bauen – das war schon immer so. In der griechischen Mythologie finden wir künstliche Kreaturen wie Thalos oder Pandora, später gibt es Frankensteins Monster oder Pinocchio. Das ist ein uralter menschlicher Wunsch.

Und ja, es ergibt Sinn, dass wir menschliche Verhaltensweisen imitieren oder auch simulieren, damit sich die Person, um die es geht, wertgeschätzt und abgeholt fühlt. Für gefährlich halte ich allerdings, wenn wir Roboter herstellen, die einzig und allein darauf ausgelegt sind, dass sie eine bestimmte emotionale Wirkung haben, dass sie versuchen, Abhängigkeiten herzustellen und Beziehungen zu festigen. In Japan gibt es ein Gerät, das aussieht wie eine Kaffeemaschine und in dem ein Hologrammmädchen wohnt. Das textet den Menschen Nachrichten, wenn diese unterwegs sind, schreibt ihnen, ich vermisse dich, komm bald zurück. Das ist Betrug und Täuschung, und der Mensch fällt aus evolutionsbiologischen Gründen darauf herein. Ich finde es schwierig, wenn wir Maschinen entwickeln, die einzig dafür da sind, dass wir sie gerne haben.

Roboter und Menschenrechte

Werden wir Roboter als Personen begreifen?

Bendel: Für mich bleibt der Roboter immer ein Ding ohne Rechte. Man kann dann in der Ethik über Bande spielen, was Vorsokratiker getan haben, oder auch Kant, und das Argument bemühen, dass man verroht, wenn man den Roboter so oder so behandelt. Das ist schon richtig, aber deshalb wird der Roboter nicht zum Objekt der Moral. Er bleibt einfach ein Ding.

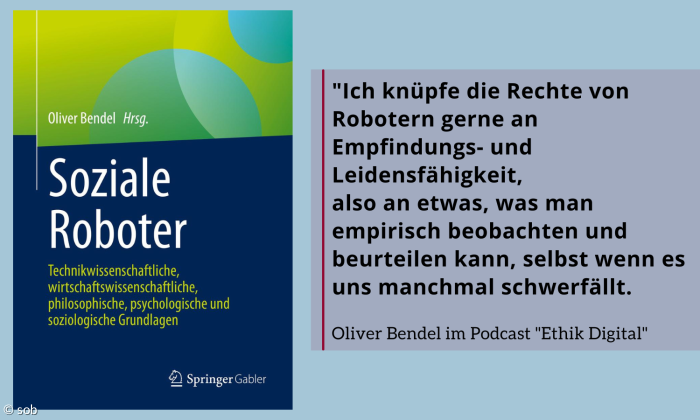

Ich knüpfe die Rechte von Robotern gerne an Empfindungs- und Leidensfähigkeit, also an etwas, was man empirisch beobachten und beurteilen kann, selbst wenn es uns manchmal schwerfällt. Wenn wir Empathie haben, dann verstehen wir, dass Schweine leiden können. Sie haben Todesangst, wenn sie merken, dass sie zum Schlachthof geführt werden. Und man muss schon sehr, sehr begrenzt sein, um das nicht wahrzunehmen und zu behaupten, Schweine seien Dinge und könnten behandelt werden wie alles Mögliche. Wir gestehen Schweinen gewisse Rechte zu, auch wenn wir sie grauenhaft behandeln.

Roboter können nicht empfinden und leiden. Sie werden das vermutlich auch nie tun können.

Und ich wehre mich dagegen, neue Entitäten einzuführen, die solche Ansprüche nicht selber geltend machen könnten, aber für die andere sprechen könnten. Es ist eine große Kluft zwischen dem Roboter, den ich schlecht behandle, und dem Menschen, den ich schlecht behandle. Und diese Kluft wird eben definiert durch Empfindungs- und Leidensfähigkeit.

Was ist nun mit der anderen Seite, der Maschine als Akteur oder Subjekt? In der Maschinenethik nehmen wir bestimmte moralische Regeln und pflanzen sie den Maschinen ein. Das funktioniert hervorragend. Roboter können sich wunderbar an Regeln halten, aber was wir produzieren, sind kleine Fundamentalisten, die sich strikt und sklavisch an Regeln halten.

Ein Beispiel dafür sind tierfreundliche Maschinen. Normale Rasenmähroboter zerhäckseln Igel. Wir definieren dann eine moralische Regel, die da lautet 'Igel sind entzückende Lebewesen, die schützenswert sind und die man nicht zerhäckseln sollte'. Und die setzen wir dann technisch um mit Wärmebildkameras und Machine Learning. Dann funktioniert die Maschine anders und für den Igel ergibt sich ein großer Unterschied. Aber das ist eine funktionale Moral. Die Maschine hat weiterhin kein Bewusstsein. Sie hat keine Empathie. Sie hat keine Intuition. Sie hat nichts davon, was unsere Moral über weite Strecken ausmacht. Was wir hier haben, ist eine sehr primitive, funktionale Moral. Aber das funktioniert, und es funktioniert fantastisch. Ich bin dafür, bestimmten Maschinen bestimmte moralische Regeln zu geben, an die sie sich halten. Und ich halte nichts davon, Maschinen Rechte zu geben. Ich glaube nicht, dass das zu etwas führt.

Wenn Roboter die Tiere schützen

Woran arbeiten Sie gerade?

Bendel: Ich beschäftige mich mit der Tier-Maschine-Interaktion. Ich habe die Vision, dass wir Naturreservate über Bodenroboter und Drohnen schützen können. Wir haben ein System konzipiert für die Gesichtserkennung bei Bären. Damit könnte vor Problembär Bruno gewarnt werden, ohne dass er vorher verchippt werden müsste. Mit Gesichtserkennung, Bewegungserkennung und Mustererkennung könnten wir Gebiete schaffen, wo sich Tiere wohlfühlen. Derzeit haben wir noch viele Probleme mit der Motorik oder Aktorik und auch mit der Geräuschentwicklung. Aber hier kann man einiges tun.

Und natürlich beschäftige ich mich auch mit GPT-3 und bald auch GPT-4, die es schaffen, auch eine bestimmte Kreativität zu zeigen und menschliche Künstler auf einem sehr hohen Niveau zu imitieren. Wir können in Zukunft den Maschinen sagen, in welcher Weise sie zum Beispiel andere Maschinen bauen sollen. Und irgendwann werden die Maschinen das selber den Maschinen sagen. Wir werden also eine Entwicklung haben, wo Systeme und Maschinen sich selber bauen und optimieren. Und das fasziniert mich sehr.

Und gruseln Sie sich dabei manchmal auch?

Bendel: Ja, das erzählen uns auch die alten Geschichten vom Zauberlehrling. Ich bin froh, dass ich Wirtschaftsinformatiker, aber auch Philosoph und Ethiker bin. Jede gute Technik kann zum Schlechten verwendet werden. Das gilt es zu reflektieren. Im Vordergrund steht für mich aber der Erkenntnisgewinn. Und das gilt für die klassische Wissenschaft genauso wie für die Ethik.

Ich bin freilich dafür, hochproblematische Entwicklungen zu verbieten. Dazu gehört ein Verbot der Gesichtserkennung zum Zwecke der Überwachung im öffentlichen Raum.

Dort ist die Politik viel zu zögerlich, denn wir haben empirische Daten und profunde Erkenntnisse, die klar machen, was dort passiert. Hier brauchen wir mehr Recht und weniger Ethik. In einer EU-Arbeitsgruppe, die Leitlinien und Richtlinien definiert, sollten von über 50 Personen nicht über 40 aus der Industrie kommen. Die EU hat viel bewegt, aber sie sollte uns wirklich auch vor der Industrie schützen. Und damit meine ich nicht nur das Militär, sondern Konzerne wie Google und Microsoft, die zum Teil noch gefährlicher sind als bestimmte militärische Einrichtungen.

Oliver Bendel: Soziale Roboter

Soziale Roboter: Technikwissenschaftliche, wirtschaftswissenschaftliche, philosophische, psychologische und soziologische Grundlagen.

579 S. 32 s/w-Abbildungen, Bibliographien.

ISBN 978-3-658-31113-1

Podcast Ethik Digital abonnieren

Der Podcast #EthikDigital von Rieke C. Harmsen und Christine Ulrich kann bei diesen Kanälen abonniert werden:

Fragen und Anregungen mailen Sie bitte an: rharmsen@epv.de

Youtube-Playliste mit allen Videos von #EthikDigital

https://www.youtube.com/playlist?list=PLb68o3_9IKtDgE9eWxDI5RU5aHRZbw85F